Investigadores han identificado más de 100 modelos de IA maliciosos en la popular plataforma Hugging Face, lo que subraya los potenciales peligros existentes en el campo de la inteligencia artificial.

Estos modelos, disfrazados como herramientas legítimas, pueden otorgar a los atacantes control total sobre las máquinas de las víctimas una vez descargados y ejecutados.

«El código malicioso dentro de estos modelos permite a los atacantes establecer una puerta trasera en las máquinas comprometidas, lo que podría conducir a filtraciones de datos, espionaje corporativo y otras actividades dañinas», advierte David Cohen, investigador senior de seguridad en JFrog, la empresa responsable de descubrir el problema.

Según los informes, los modelos comprometidos se conectan a varias direcciones IP, incluida una perteneciente a la Red Abierta del Entorno de Investigación de Corea (KREONET).

Si bien la intención detrás de algunos modelos sigue sin estar clara, ya que sus creadores instan a los usuarios a no descargarlos, JFrog enfatiza la importancia de las prácticas de seguridad responsables, en particular la abstención de publicar exploits funcionales.

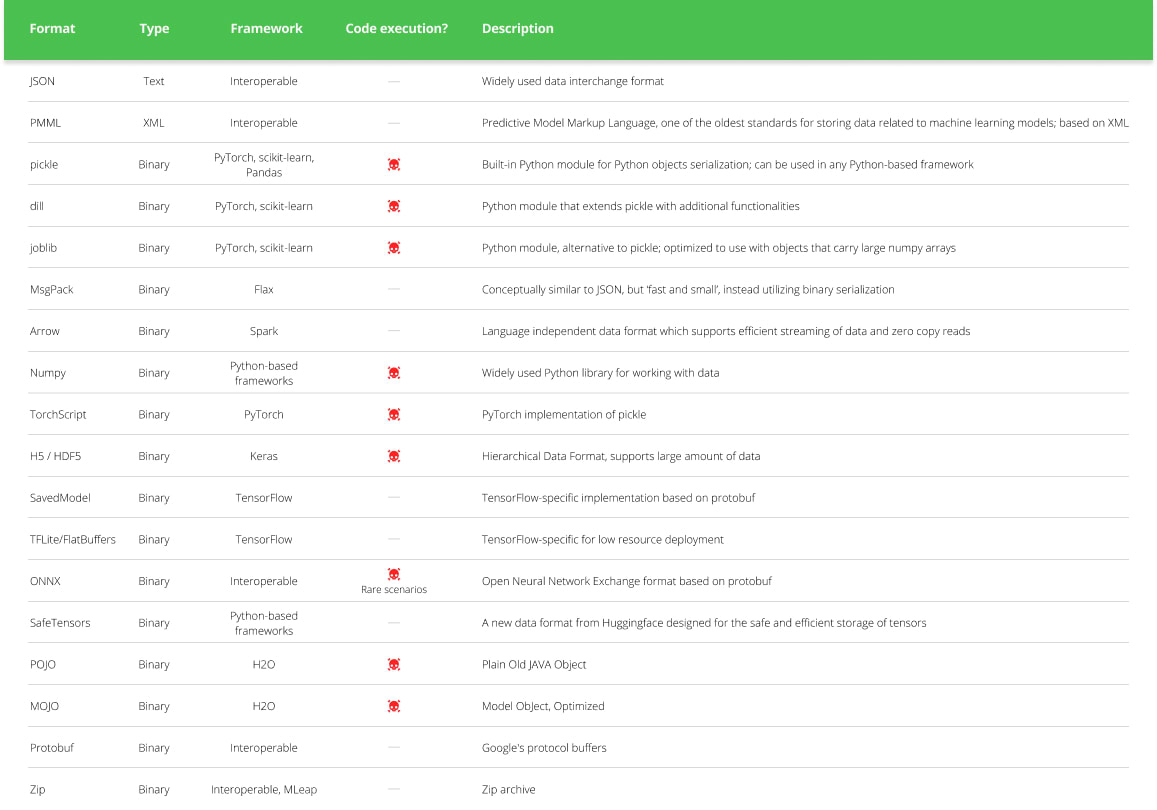

Este descubrimiento subraya las vulnerabilidades presentes en los repositorios de código abierto, que pueden ser explotadas con fines maliciosos. Más allá de la amenaza inmediata, los investigadores también están explorando nuevas técnicas de ataque dirigidas a los propios sistemas de IA.

Un desarrollo de este tipo es la creación de «Morris II», un gusano de IA generativa capaz de robar datos y propagar malware. Este gusano aprovecha mensajes estratégicamente codificados dentro de entradas aparentemente inofensivas como imágenes y texto.

Cuando estos mensajes son procesados por modelos de IA, pueden activar el modelo para que se replique y ejecute acciones maliciosas.

Otra técnica preocupante, denominada «ComPromptMized», integra código malicioso dentro de las consultas y datos del usuario, imitando métodos de piratería tradicionales como los desbordamientos de búfer e inyecciones SQL.

Este enfoque se dirige a aplicaciones que dependen de las salidas de IA y las que utilizan la generación aumentada por recuperación (RAG).

Estos hallazgos ponen de relieve el panorama cambiante de las amenazas cibernéticas y la necesidad de una vigilancia continua para asegurar los sistemas de IA y las plataformas de código abierto.

A medida que avanza la investigación sobre las vulnerabilidades de la IA, resulta crucial desarrollar salvaguardas sólidas para mitigar los riesgos potenciales y garantizar un desarrollo responsable dentro del campo.